Comparativa de Modelos en Dificultad Matemática

Análisis de la Comparación de Modelos en Niveles de Dificultad Matemática

Comparación de Modelos

- Modelos Involucrados:

- OpenMath2-Llama3.1-8B: Este modelo parece ser una versión especializada o mejorada, presumiblemente enfocada en resolver problemas matemáticos con mayor precisión.

- Llama3.1-8B-Instruct: Un modelo instructivo posiblemente diseñado para seguir instrucciones o guiar en soluciones matemáticas pero con un enfoque menos directo que el modelo OpenMath2.

Desempeño en Diferentes Niveles de Dificultad

Tabla de Exactitud (Accuracy)

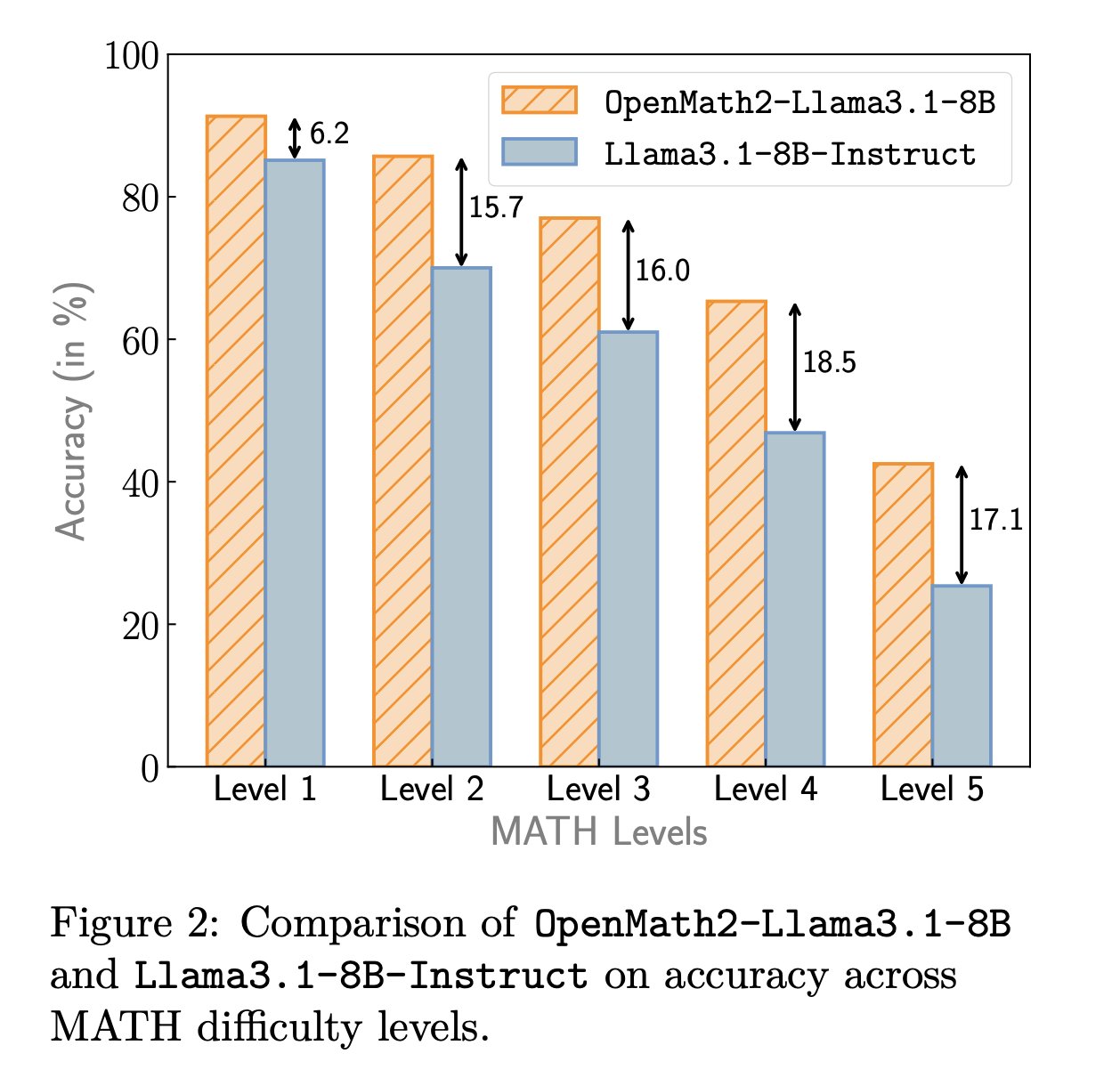

| Nivel | OpenMath2-Llama3.1-8B | Llama3.1-8B-Instruct | Diferencia |

|---|---|---|---|

| Level 1 | ~88% | ~82% | 6.2 |

| Level 2 | ~75% | ~59% | 15.7 |

| Level 3 | ~65% | ~49% | 16.0 |

| Level 4 | ~55% | ~36% | 18.5 |

| Level 5 | ~35% | ~18% | 17.1 |

Observaciones Detalladas

-

Level 1:

- El rendimiento de ambos modelos es muy alto. Sin embargo, OpenMath2 supera a Llama3.1 con una diferencia de 6.2%, indicando que ya desde los niveles básicos, la mejora en entrenamiento o estructura del modelo tiene impacto.

-

Level 2 a Level 5:

- A medida que la dificultad aumenta, la diferencia en exactitud entre los modelos también lo hace, sugiriendo que OpenMath2-Llama3.1-8B maneja mejor el incremento en la complejidad de problemas matemáticos.

- Especialmente notable es la diferencia en Level 4 y Level 5, donde el modelo mejorado supera al otro por márgenes significativos, 18.5% y 17.1% respectivamente. Esto podría ser importante para aplicaciones que requieren alta precisión en problemas matemáticos complejos.

Implicaciones y Reflexiones

- Aplicación Práctica:

- Los resultados sugieren que para tareas o aplicaciones más desafiantes matemáticamente, OpenMath2-Llama3.1-8B podría ser una opción preferible, dado su mejor rendimiento en niveles de dificultad más altos.

- Consideraciones para el Desarrollo:

- La mejora en el rendimiento a través de la especialización del modelo indica un camino prometedor para el desarrollo de IA enfocada en tareas específicas. Esto resalta la importancia de la adaptación del modelo a necesidades específicas del dominio de aplicación.

Reference:

huggingface.co

Llama-3.2 vs. Llama-3.1 LLMs and Smaller Models (3B, 1B) in ...

www.youtube.com

Tool Calling Showdown: Llama3.1 8B vs 70B - YouTube

www.reddit.com

Llama 3.1 benchmarks from Meta related Hugging Face Upload